NVIDIA Blackwell GPU – siêu chip mạnh nhất thế giới cho AI

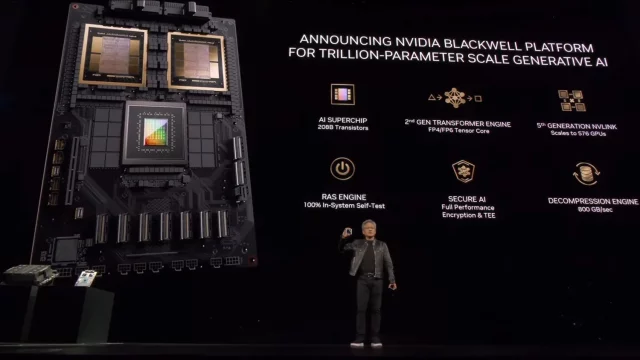

Ngày 18-3-2024 tại hội nghị thường niên dành cho các nhà phát triển NVIDIA GTC (GPU Technology Conference) 2024 ở San Jose (Mỹ), ông Jensen Huang, CEO của NVIDIA, đã chính thức giới thiệu thế hệ chip AI mới là Blackwell GPU có khả năng huấn luyện AI tạo sinh (generative AI) lên tới hàng ngàn tỷ tham số (trillion-parameter). GPU Blackwell được giới thiệu là siêu chip mạnh nhất thế gIới hiện nay cho AI.

Ông Jensen Huang, CEO của NVIDIA, giới thiệu GPU Blackwell tại NVIDIA GTC 2024. (Ảnh: NVIDIA)

Bộ xử lý đồ họa dành cho trí tuệ nhân tạo (AI) Blackwell này có giá vẫn nằm trong khoảng giá tương tự như người tiền nhiệm của nó là chip Hopper H100 ra đời năm 2022, vốn có giá từ 25.000 đến 40.000 USD mỗi chip. Và trong cuộc trả lời phỏng vấn của hệ thống truyền hình CNBC, ông Jensen Huang cho biết rằng NVIDIA có kế hoạch bán GPU Blackwell của mình cho khối lượng công việc AI và HPC với giá từ 30.000 đến 40.000 USD. Tuy nhiên, đó chỉ là mức giá tương đối vì NVIDIA có xu hướng bán toàn bộ khối xây dựng trung tâm dữ liệu chứ không chỉ riêng bộ tăng tốc.

Như vậy, bình quân mỗi 2 năm, NVIDIA lại đưa ra một thế hệ chip AI mới. Trong chương trình truyền hình “Squawk on the Street” của hệ thống CNBC hôm 19-3-2024, ông Jensen Huang chia sẻ rằng: “Chúng tôi đã phải phát minh ra một số công nghệ mới để biến điều này thành hiện thực.” CEO NVIDIA cũng ước tính chi phí nghiên cứu và phát triển (R&D) mà hãng chi cho các thiết kế và kiến trúc GPU tiên tiến của mình vào khoảng 10 tỷ USD. Ông Jensen Huang giải thích: chi phí không chỉ nằm ở con chip mà còn bao gồm thiết kế các trung tâm dữ liệu và tích hợp chúng vào trung tâm dữ liệu của các công ty khác.

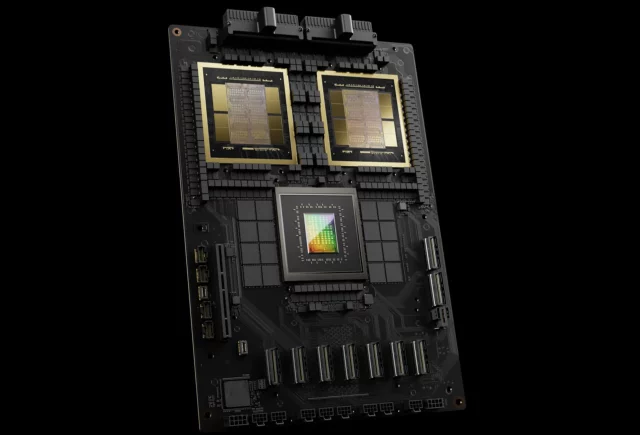

Blackwell GPU gồm 2 die riêng rẽ được kết hợp trên 1 con chip. Nó được gia công bởi hãng TSMC.

GPU Blackwell B200 (bên trái) và H100. (Ảnh: NVIDIA)

Chip Blackwell B200 có kích thước lớn hơn H100. Blackwell có 208 tỷ bóng bán dẫn (104 tỷ mỗi die), cao gấp đôi so với 80 tỷ transistor trên chip H100, có năng lực xử lý AI đạt 20 petaflop (20 triệu tỷ phép tính mỗi giây), gấp năm lần mức 4 petaflop của H100. Theo NVIDIA, trên thực tế, Blackwell xử lý tác vụ nhanh gấp 7-30 lần H100, đồng thời giảm 25 lần chi phí cũng như mức tiêu thụ năng lượng. CEO NVIDIA đã ví dụ rằng: trước đây việc huấn luyện một mô hình AI 1.800 tham số cần đến 8.000 GPU H100 và 15 megawatt điện. Giờ đây, khối lượng công việc tương tự có thể thực hiện được với 2.000 GPU B200 và 4 megawatt điện.

Khi tiến hành benchmark trên mô hình GPT-3 LLM với 175 tỷ thông số, NVIDIA cho biết GB200 có hiệu năng bét nhất cũng hơn gấp bảy lần so với H100 và cung cấp tốc độ đào tạo AI nhanh hơn gấp bốn lần.

GPU Blackwell. (Ảnh: NVIDIA)

NVIDIA nói rằng một trong những cải tiến quan trọng là công cụ chuyển đổi thế hệ thứ hai (second-gen transformer engine) giúp tăng gấp đôi khả năng tính toán, băng thông và kích thước mô hình bằng cách sử dụng 4 bit cho mỗi neuron thay vì 8 bit. Điểm khác biệt quan trọng thứ hai giúp liên kết số lượng lớn các GPU này là bộ chuyển đổi NVLink thế hệ tiếp theo cho phép 576 GPU giao tiếp với nhau với băng thông hai chiều 1,8 terabyte mỗi giây.

Điều đó đòi hỏi NVIDIA phải phát triển một chip chuyển mạch mạng hoàn toàn mới, có 50 tỷ bóng bán dẫn và một số điện toán onboard của riêng nó với khả năng 3,6 teraflop FP8.

NVIDIA đã công bố 2 phiên bản GPU Blackwell có cấu hình khác nhau là B100 và B200, cùng gói GB200 (gồm 2 GPU Blackwell + 1 CPU Grace Arm trên một PCB).

Blackwell GB200. (Ảnh: NVIDIA)

Đối với khách hàng mua số lượng lớn, NVIDIA có tùy chọn đóng gói nhiều chip vào một thiết kế duy nhất, gọi là GB200 NVL72. Gói GB200 NVL72 chứa 72 chip AI, 36 bộ xử lý trung tâm CPU, 600.000 bộ phận, có 5.000 sợi cáp riêng rẽ với tổng chiều dài cáp gần 2 dặm, và tất cả nằm gọn trong một rack (giá) được làm mát bằng chất lỏng, nặng 1.361kg. GB200 NVL72 cung cấp sức mạnh lên đến 720 petaflops (triệu tỷ phép tính mỗi giây) cho huấn luyện AI hay 1.440 petaflops (tức 1.4 exaflops) cho suy luận. Mỗi khay (tray) trong giá (rack) chứa hai GB200 hoặc hai bộ chuyển mạch NVLink. Tổng cộng, NVIDIA cho biết một trong những rack này có thể hỗ trợ mô hình 27 nghìn tỷ tham số. Mô hình GPT-4 hiện nay được cho là có 1,7 nghìn tỷ tham số.

CEO NVIDIA cũng cho biết rằng Amazon, Google, Microsoft và Oracle sẽ dùng GB200 NVL72 cho trung tâm dữ liệu của mình

NVIDIA cũng sẵn sàng cung cấp cho các công ty phần còn lại của giải pháp. Đó là DGX Superpod dành cho DGX GB200, kết hợp tám hệ thống thành một để có tổng cộng 288 CPU, 576 GPU, bộ nhớ 240TB và 11,5 exaflop điện toán FP4.

NGÔ LÊ

Nguồn từ NVIDIA và các kênh khác.