Deepfake nguy hiểm khôn lường hơn với AI

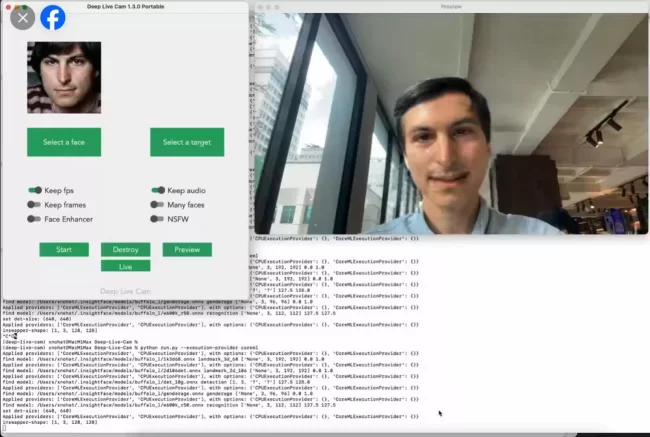

Một chuyên gia an ninh mạng có tiếng của Việt Nam sáng 11-8-2024 post một video clip dùng công nghệ giả mạo AI Deepfake được tạo ra chỉ bằng một tấm ảnh chân dung của ai đó. Anh muốn chứng minh cho cộng đồng mạng xã hội biết rằng, công nghệ Deepfake mà được hỗ trợ bởi khả năng trí tuệ nhân tạo AI hiện nay sẽ trở nên “siêu cấp”. Nếu có được file (dữ liệu) giọng nói của người đó thì video giả danh sẽ càng “thật hơn các loại thật”.

Chuyên gia an ninh mạng thử dùng một tấm ảnh chân dung bất kỳ để tạo video deepfake. (Ảnh từ FB nhân vật được cho phép sử dụng).

Chúng tôi cũng từng suýt trở thành nạn nhân của Deepfake. Một sư huynh cùng trường trung học xưa đang định cư ở Mỹ lâu ngày không liên lạc bỗng dưng nhắn tin thăm hỏi. Anh ấy hỏi thăm những thầy cô và bạn học chung mà chúng tôi biết. Tin quá đi thôi. Hôm trước nhắn tin hỏi thăm, bữa sau, anh sư huynh nhắn tin nhờ giúp một việc. Đó là anh muốn gửi tiền về giúp cho một đứa cháu, mà cần rất gấp, nhưng lại chưa kịp đi gửi tiền về, nhờ chúng tôi ứng trước giùm, anh sẽ gửi về trả sau. Rồi như muốn làm tin, anh ta gọi video call. Chỉ có điều cuộc gọi video call đó chỉ nhá lên vài giây cho thấy hình ảnh đúng là anh sư huynh đó đang lái xe rồi phụt tắt. Chúng tôi gọi điện lại mấy lần mà anh ấy không nghe máy. Anh ta nhắn tin là mình đang lái xe không thể nghe điện thoại. Chúng tôi vốn tính đa nghi nên suy ra: “đang lái xe không thể nghe điện thoại nhưng vẫn nhắn tin được”. Vậy là có mùi “âm mưu”. Mấy ngày sau, qua kênh liên lạc khác, chúng tôi gặp được chính anh sư huynh và được xác nhận là anh ấy chưa từng liên lạc nhờ vả như vậy.

Mạo danh bằng Deepfake đang lộng hành ở Việt Nam. (Ảnh từ Internet. Thanks).

Một hãng tin lớn của Anh giựt tít: “Deepfake khiêu dâm: Phải chăng lần tới có thể là bạn?”. Tác giả viết rằng: Hầu hết mọi người nghĩ rằng Deepfake là những đoạn video clip bị chỉnh sửa của các nhà lãnh đạo thế giới, được thiết kế để gây nhầm lẫn, nhưng mối đe dọa cấp bách nhất của Deepfake không phải là chính trị, mà là khiêu dâm. Nghiên cứu cho thấy khoảng 96% video Deepfake là khiêu dâm, với gần 100% trong số đó liên quan đến phụ nữ – những người bị mạo danh. Dẫn chứng là trường hợp ba người phụ nữ đã bị lạm dụng tình dục qua hình ảnh bằng Deepfake, bao gồm Lauren Book – nữ thượng nghị sĩ xinh đẹp của bang Florida (Mỹ), nhà vận động người Anh Kate Isaacs và Dina – một người phụ nữ bị một đồng nghiệp chơi xấu. Theo hãng tin, Deepfake đã gây ra cho những người phụ nữ này những “hậu quả tàn khốc” về mặt cảm xúc và tâm lý.

Hồi tháng 2-2024, Công ty công nghệ Bkav đã đưa ra cảnh báo: Ngay cả khi bạn thực hiện một cuộc gọi video và thấy mặt người thân hay bạn bè, nghe đúng giọng nói của họ thì cũng không hẳn bạn đang nói chuyện với chính người đó. Gần đây, nhiều người đã trở thành nạn nhân của các cuộc lừa đảo tài chính sử dụng Deepfake với cấp độ “siêu” hơn do được tích hợp công nghệ AI.

Chẳng hạn như trường hợp của chị Nguyễn Thanh Hương (tên nhân vật đã được thay đổi) là nhân viên văn phòng tại Hà Nội. Trong một lần trò chuyện với bạn qua Facebook Messenger, người bạn của chị Hương đã chào và kết thúc câu chuyện, nhưng đột nhiên quay lại nhắn tin, hỏi vay tiền và đề nghị chuyển tiền vào một tài khoản ngân hàng. Dù tên tài khoản trùng khớp với tên bạn mình, chị vẫn thoáng nghi ngờ nên yêu cầu gọi video để xác thực. Người bạn đồng ý ngay, nhưng cuộc gọi chỉ kéo dài vài giây do “mạng chập chờn”, theo giải thích của người bạn. Đã thấy mặt bạn mình trong cuộc gọi video, giọng nói cũng đúng của người này, chị không còn nghi ngờ và chuyển tiền. Tuy nhiên, chỉ sau khi chuyển tiền thành công, chị Hương mới biết mình đã mắc bẫy của hacker.

Nửa cuối năm 2023, Bkav liên tục nhận được các báo cáo cũng như yêu cầu trợ giúp của nạn nhân về các vụ việc lừa đảo tương tự. Theo các chuyên gia của Bkav, kẻ xấu sử dụng AI để tạo sẵn một đoạn video (Deepfake) giả mạo gương mặt và giọng nói của chủ tài khoản Facebook mà chúng đã âm thầm chiếm đoạt trước đó. Khi được yêu cầu gọi điện video call để chứng thực, chúng đồng ý nhận cuộc gọi, nhưng sau đó nhanh chóng ngắt kết nối để tránh bị phát hiện. Ông Nguyễn Tiến Đạt, Tổng Giám đốc Trung tâm Nghiên cứu Mã độc (AntiMalware) của Bkav, cho biết: “Khả năng thu thập và phân tích dữ liệu người dùng thông qua AI cho phép tạo ra những chiến lược lừa đảo tinh vi. Điều này cũng có nghĩa là mức độ phức tạp của các kịch bản lừa đảo khi kết hợp giữa Deepfake và GPT sẽ ngày càng cao, khiến việc nhận diện lừa đảo sẽ khó khăn hơn rất nhiều.”

Báo South China Morning Post cho biết: Một vụ lừa đảo bằng Deepfake chấn động thế giới đã xảy ra tại Hồng Kông – Trung Quốc hồi tháng 2-2024. Một nhân viên tài chính của Công ty Kỹ thuật Arup (Anh) đã bị lừa chuyển hơn 25 triệu USD cho những kẻ lừa đảo dùng Deepfake để dựng lên cả một cuộc gọi trực tuyến của giám đốc tài chính của công ty cùng một số nhân viên công ty. Ngay trong cuộc họp có đông người chứng kiến đó, nhân viên tài chính đã nhận được “lệnh” chuyển tiền từ chính “sếp” của mình, mà không biết đó là “sếp Deekfake”.

Cũng với thủ đoạn “cuộc gọi trực tuyến” bằng Deepfake, bọn tội phạm công nghệ đã lừa được một nữ nhân viên tài chính ở tỉnh Sơn Tây (Trung Quốc) chuyển cho chúng 1,86 triệu nhân dân tệ (khoảng 262.000 USD) do tuân lệnh của “sếp” gọi điện online cho mình.

Các chuyên gia cảnh báo, những kẻ xấu không chỉ lợi dụng Deepfake để lừa đảo chiếm đoạt tài sản; mà giờ đây với sự “thêm tay thêm chân” vi diệu của AI, chúng còn lợi dụng công nghệ mạo danh “đỉnh chóp” này nhằm nhiều mục đích khác. Trên thế giới đã xảy ra nhiều vụ Deepfake thao túng giá cổ phiếu, bôi nhọ thương hiệu và cá nhân, tung tin giả, tống tiền,… Tổ chức thống kê Statista cho biết: Ngoài con đường chính là tạo ra nội dung khiêu dâm không có sự đồng thuận liên quan chủ yếu đến những người nổi tiếng là phụ nữ, công nghệ Deepfake cũng có thể được sử dụng để thực hiện hành vi gian lận danh tính bằng cách tạo ID giả hoặc mạo danh người khác qua điện thoại. Báo cáo thường niên gần đây nhất của nhà cung cấp xác minh danh tính Sumsub cho thấy, các trường hợp gian lận danh tính liên quan đến Deepfake đã tăng vọt trong khoảng thời gian từ năm 2022 đến năm 2023 tại nhiều quốc gia trên thế giới. Báo cáo đã phân tích hơn 2 triệu âm mưu lừa đảo tại 224 nước và vùng lãnh thổ. Trong vòng một năm qua, số vụ lừa đảo Deepfake có AI là “đồng phạm” đã tăng vọt cao nhất tới 4.500% tại Philippines; kế đó là 3.050% tại Việt Nam; 3.000% ở Mỹ; 2.950% ở Bỉ; 2.800% ở Nhật Bản,…

Một cuộc khảo sát 199 nhà lãnh đạo an ninh mạng tham dự Cuộc họp Thường niên về An ninh mạng của Diễn đàn Kinh tế Thế giới (World Economic Forum Annual Meeting on Cybersecurity) năm 2023 cho thấy có tới 46% trả lời rằng mối lo ngại nhất của họ là về “sự tiến bộ của các khả năng đối đầu – lừa đảo, phát triển phần mềm độc hại, deepfake” về mặt rủi ro mà AI gây ra cho an ninh mạng trong tương lai.

Trở lại Việt Nam, ngày 9-8-2024, Trung tâm Xử lý tin giả, thông tin xấu độc Việt Nam (VAFC) thuộc Cục Phát thanh, Truyền hình và Thông tin điện tử (Bộ Thông tin và Truyền thông) đã phát đi cảnh báo rằng: Tống tiền bằng Deepfake là hình thức lừa đảo mới nguy hiểm. Gần đây, Trung tâm đã nhận được phản ánh từ ông QTL (HB) về việc các đối tượng xấu đã sử dụng công nghệ Deepfake để thực hiện hành vi cắt ghép ảnh chân dung của ông tạo ra và phát tán các hình ảnh nhạy cảm có hình ảnh ông trên mạng xã hội nhằm bôi nhọ danh dự, nhân phẩm và uy tín cá nhân của ông. Sau đó bọn chúng đã sử dụng những hình ảnh giả mạo này để tống tiền, yêu cầu ông chuyển tiền vào ví điện tử và liên hệ qua email để xác nhận.

Trung tâm VAFC khuyến cáo người dân nâng cao cảnh giác và thực hiện các biện pháp phòng ngừa sau:

- Cẩn trọng với những yêu cầu kết bạn từ người lạ trên mạng xã hội.

- Tuyệt đối không chia sẻ thông tin cá nhân, hình ảnh, video riêng tư với người không quen biết.

- Kiểm tra kỹ nguồn gốc thông tin, hình ảnh, video trước khi chia sẻ.

- Báo cáo ngay cho cơ quan chức năng khi phát hiện các trường hợp nghi ngờ lừa đảo, tống tiền bằng Deepfake.

Nếu bạn là nạn nhân của hình thức lừa đảo này, hãy:

- Giữ lại tất cả bằng chứng liên quan (tin nhắn, email, hình ảnh, video…).

- Không chuyển tiền cho kẻ tống tiền.

- Liên hệ ngay với cơ quan công an gần nhất để được hỗ trợ.

Việc ứng dụng trí tuệ nhân tạo với lợi thế là khả năng thu thập thông tin, xử lý dữ liệu lớn,… đã được ứng dụng trong hoạt động chứng khoán từ vài năm nay. Đã có nhiều phần mềm, ứng dụng AI chuyên về chứng khoán. Ngay cả riêng chó Việt Nam cũng đã có nền tảng Simplize sử dụng mô hình Nebula AI được đào tạo từ nguồn dữ liệu thực của thị trường chứng khoán Việt Nam. Về mặt tích cực, AI giúp nhà đầu tư thu thập và phân tích dữ liệu, đưa ra những gợi ý, loại bỏ yếu tố cảm tính khỏi các quyết định mua và bán của họ.

Hồi giữa năm 2024, Công ty Chứng khoán VPS (VPS) đã đưa ra cảnh báo với khách hàng về hình thức lừa đảo mới Deepfake.Theo đó, thời gian gần đây, các tổ chức tài chính đã ghi nhận nhiều trường hợp kẻ gian sử dụng công nghệ lừa đảo Deepfake để giả dạng hình ảnh và giọng nói nhằm mục đích dẫn dụ, lừa đảo người bị hại mở các tài khoản ảo hoặc đánh cắp thông tin nhạy cảm, thông tin xác thực sinh trắc học. Từ các thông tin này, bọn xấu có thể tạo lập các tài khoản giả danh, có thể đánh lừa được các thủ tục xác thực sinh trắc học của các sàn giao dịch để vào gây rối.

Các nhà nghiên cứu bảo mật của Công ty IBM (Mỹ) đã chứng minh rằng, bọn tội phạm công nghệ có thể sử dụng AI tạo sinh và công nghệ Deepfake âm thanh/hình ảnh để chiếm quyền điều khiển và thao túng các cuộc hội họp online bằng âm thanh hay các video.

Các chuyên gia an ninh mạng lưu ý rằng mọi người trong kỷ nguyên AI phải chuẩn bị cho mình khả năng đối phó với những hành vi của bọn xấu lợi dụng công nghệ AI hữu ích này. Cảnh giác và luôn cảnh giác. Cách an toàn nhất là cẩn trọng với tất cả các thông tin chữ, hình ảnh, video, trên mạng, đặc biệt là mạng xã hội. Không chỉ không tin ngay, mà còn không chia sẻ chúng cho tới khi có thể xác minh nguồn gốc chính thức và tính xác thực. Bản thân mọi người cũng phải luôn cảnh giác với những tin nhắn, cuộc gọi nhờ vả, vay tiền, hay chào mời tham gia các “dự án” loại “việc nhẹ, lương cao”, “đầu tư ít, thu tiền nhiều”,… Không nên quá tin vào các cuộc gọi video có mục đích xác thực danh tính, mà cần kiểm tra chéo bằng những kênh liên lạc khác.

Bản in trên báo Người Lao Động thứ Tư 14-8-2024 và trên báo NLĐ Online.

ANH PHÚC