Câu chuyện các ông lớn công nghệ tiếp cận AI có trách nhiệm ra sao?

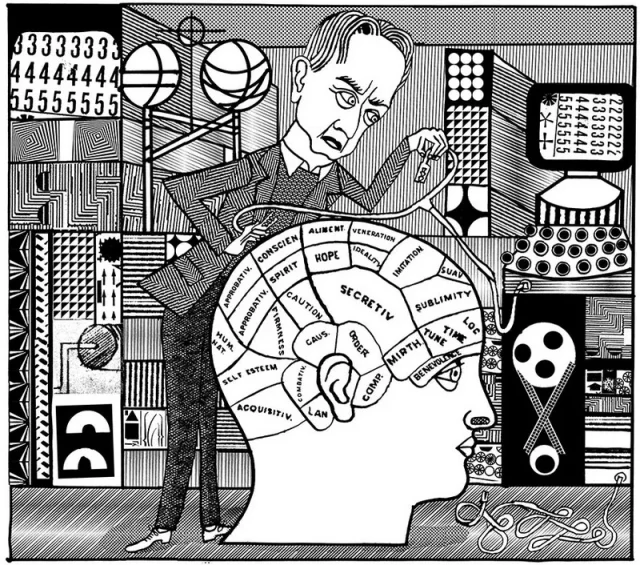

Lý do mà Tiến sĩ Geoffrey Hinton, người được coi là “Cha đỡ đầu” (godfather) của trí tuệ nhân tạo (AI) rời khỏi Google hồi hạ tuần tháng 4-2023, sau 10 năm gia nhập tập đoàn công nghệ này tiếp tục phát triển AI, theo ông xác nhận là để có thể công khai cảnh báo về sự nguy hiểm của công nghệ này. “Nhà AI học” 75 tuổi này từng được trao giải thưởng Turing 2018, giống như “Nobel Tin học”, cho nghiên cứu của ông về trí tuệ nhân tạo.

Sau hơn một thập niên tham gia phát triển AI, Tiến sĩ Hinton hiểu rõ chân tơ kẽ tóc công nghệ mới này, biết được sức mạnh và những lợi ích của nó đem lại cho con người; nhưng đồng thời cũng nhận thức được những mặt trái của AI mà nếu bị lạm dụng, sử dụng không đúng đắn sẽ gây nguy hại ra sao. Ngặt nỗi, cũng như với hầu hết doanh nghiệp, ông phải chịu sự ràng buộc bởi những quy định nội bộ của Google, cụ thể là không được nói gì có liên quan đến công việc của mình. Cuối cùng, để có thể thoải mái cảnh báo về những nguy hiểm của AI, ông phải chọn giải pháp rời Google. Tuy nhiên, trong một tweet trên Twitter hôm 1-5-2023, Tiến sĩ Hinton viết rằng: “Google đã hành động rất có trách nhiệm.”

Mọi chuyện của Tiến sĩ Hinton với AI ở Google diễn ra êm xuôi mà theo ông nói với báo New York Times là cho đến năm 2022, ông vẫn tin rằng Google đã có “sự quản lý thích hợp” (proper steward) về AI. Là một người từng cùng 2 sinh viên của mình tại Đại học Toronto (Canada) xây dựng được một mạng thần kinh nhân tạo (neural net) – nền tảng trí tuệ cho AI, vào năm 2012, ông hiểu rõ AI và lượng định được những mặt trái của công nghệ siêu đẳng này. Mọi chuyện bắt đầu chuyển biến khác đi khi công ty khởi nghiệp OpenAI ra mắt ứng dụng AI ChatGPT hồi cuối năm 2022 dấy lên làn sóng ứng dụng AI toàn cầu. Đặc biệt là khi Microsoft quyết định tích hợp ChatGPT vào công cụ tìm kiếm Bing của mình – đối thủ cạnh tranh trực diện của công cụ tìm kiếm Google. Cuộc cạnh tranh khốc liệt trên thị trường chắc chắn sẽ làm thay đổi những quan điểm và cach hành xử về AI của các doanh nghiệp, bao gồm các ông lớn công nghệ.

Hồi tháng 7-2022, Google đã sa thải kỹ sư phần mềm Blake Lemoine với lý do vi phạm chính sách của công ty. Đó là sau khi viên kỹ sư này đưa ra nhận xét rằng chatbot AI LaMDA của Google là “có tri giác” (self-aware person). Đây không phải là chuyện lùm xùm đầu tiên về AI. Hồi tháng 12-2020, Timnit Gebru, đồng lãnh đạo nhóm AI đạo đức của Google, thông báo cô đã bị đột ngột sa thải. Chuyện này liên quan đến việc trước đó Gebru đã cố gắng xuất bản một bài báo về sự nguy hiểm của các mô hình xử lý ngôn ngữ lớn (LLM).

Tiến sĩ Geoffrey Hinton, “Cha đỡ đầu” (godfather) của trí tuệ nhân tạo (AI). (Ảnh: Internet. Thanks.)

Tiến sĩ Hinton cho biết: mối nguy trước mắt mà AI đang tạo ra là bị những kẻ xấu lạm dụng khiến ảnh, video, văn bản giả với trình độ siêu hơn tràn ngập Internet. Ông cảnh báo: AI đang tạo ra một thế giới “nơi có nhiều thứ mà người ta không thể phân biệt đâu là giả, đâu là thật”. AI cũng đang thay đổi sâu sắc thị trường việc làm, lấy đi từ con người ngày càng nhiều công việc.

Trong một cuộc trả lời phỏng vấn của báo New York Times hồi tháng 5-2023, Tiến sĩ Hinton thừa nhận mình đã sai khi đánh giá khả năng phát triển của AI. Ông nói: “Ý tưởng rằng thứ này thực sự có thể thông minh hơn con người – một số người tin vào điều đó. Nhưng hầu hết mọi người đều nghĩ rằng nó giờ đã đi quá xa. Và tôi nghĩ nó đã đi xa rồi. Tôi tưởng phải 30 đến 50 năm hoặc thậm chí lâu hơn nữa. Rõ ràng là tôi không còn nghĩ như vậy nữa”.

Trong một thông cáo trên CNN hồi giữa năm 2023, ông Jeff Dean, nhà khoa học trưởng của Google, trấn an rằng: “Là một trong những công ty đầu tiên ban hành Nguyên tắc AI, chúng tôi vẫn cam kết thực hiện cách tiếp cận có trách nhiệm với AI. Chúng tôi liên tục học cách hiểu những rủi ro mới nổi, đồng thời mạnh dạn đổi mới.”

Năm 2018, Google cam kết không sử dụng AI trong các ứng dụng liên quan đến vũ khí, giám sát được coi là vi phạm các tiêu chuẩn quốc tế hoặc hoạt động theo cách đi ngược lại nhân quyền. Google đã ban hành một bộ nguyên tắc AI cấm các hoạt động có liên quan đến vũ khí, nhưng không loại trừ việc bán kết quả nghiên cứu cho quân đội. Google cũng đã cam kết không gia hạn hợp đồng Project Maven, liên quan đến việc sử dụng AI để phân tích các cảnh quay từ máy bay không người lái. Cũng vào năm 2018, một nhóm kỹ sư phần mềm có ảnh hưởng ở Google đã trì hoãn thành công việc phát triển một tính năng bảo mật có thể giúp công ty giành được các hợp đồng quân sự.

Trước đó, ngày 20-1-2020, ông Sundar Pichai, CEO của Alphabet và Google, từng nhấn mạnh trong một hội nghị về AI tại Brussels (Bỉ) rằng: “Lịch sử từng chứng kiến rất nhiều ví dụ liên quan đến các ảnh hưởng tiêu cực khi công nghệ bị sử dụng sai mục đích. Trong khi AI hứa hẹn mang lại những lợi ích khổng lồ cho Châu Âu và thế giới, có những quan ngại thật sự về những hậu quả tiêu cực tiềm tàng của AI.” Ông kêu gọi các cơ quan quản lý thực hiện “cách tiếp cận tương xứng” khi soạn thảo các quy tắc về AI.

Gần đây hơn, ngày 24-5-2023, ông Thierry Breton, người đứng đầu về công nghiệp của Liên minh Châu Âu (EU) cho biết Alphabet, công ty mẹ của Google, và Ủy ban Châu Âu (EC) đã đồng ý đặt mục tiêu phát triển một hiệp ước AI liên quan đến các công ty Châu Âu và ngoài Châu Âu để có các quy định quản lý công nghệ này.

Trong khi đó, vào trung tuần tháng 11-2023, Meta, công ty mẹ của Facebook, đã gây chú ý khi tiến hành giải tán Nhóm AI có trách nhiệm (Responsible AI). Hầu hết thành viên của nhóm này được điều chuyển đến Nhóm trí tuệ nhân tạo tạo sinh (generative AI) mà Meta hình thành hồi tháng 2-2023 đễ làm ra các sản phẩm AI tạo sinh.

Trang công nghệ The Verger (18-11-2023) cho biết: Nisha Deo, Đại diện truyền thông của Meta AI, nói với The Verge trong email rằng sự thay đổi này nhằm hỗ trợ phát triển các tính năng AI, nhưng công ty sẽ “tiếp tục ưu tiên và đầu tư vào phát triển AI an toàn và có trách nhiệm”. Deo nói thêm rằng mặc dù các thành viên của nhóm RAI hiện đang ở trong tổ chức AI tạo sinh, nhưng họ sẽ “tiếp tục hỗ trợ các nỗ lực xuyên Meta có liên quan trong việc phát triển và sử dụng AI có trách nhiệm”.

Microsoft, nhà đầu tư hơn 10 tỷ USD vào OpenAI từ năm 2019 đến nay, và đang tích hợp AI vào nhiều dịch vụ và sản phẩm cốt lõi của mình, kể cả Windows 11 và Windows 10, luôn khẳng định theo đuổi AI có trách nhiệm. Trên trang Responsible AI thuộc Microsoft AI xuất hiện dòng tuyên bố về các nguyên tắc và cách tiếp cận AI: “Chúng tôi cam kết bảo đảm các hệ thống AI được phát triển một cách có trách nhiệm và theo cách bảo đảm sự tin tưởng của mọi người.” Bà Natasha Crampton, người đứng đầu AI có trách nhiệm của Microsoft, khẳng định: “AI là một công nghệ được xây dựng bởi con người và cho con người”. Microsoft tin rằng khi tạo ra những công nghệ có thể thay đổi thế giới, công ty cũng phải bảo đảm rằng công nghệ đó được sử dụng một cách có trách nhiệm. Microsoft cam kết tạo ra AI có trách nhiệm theo thiết kế. Công việc của Microsoft AI được hướng dẫn bởi bộ sáu nguyên tắc cốt lõi và công ty đang áp dụng những nguyên tắc đó vào thực tế trên toàn công ty để phát triển và triển khai AI sẽ có tác động tích cực đến xã hội.

Ngày 26-7-2023, “bộ tứ AI” gồm Microsoft, Google, OpenAI và Anthropic đã công bố thành lập Diễn đàn Mô hình Biên (Frontier Model Forum), một tổ chức công nghiệp mới tập trung vào việc bảo đảm sự phát triển an toàn và có trách nhiệm của các mô hình AI biên. Diễn đàn này sẽ dựa trên kiến thức chuyên môn về kỹ thuật và vận hành của các công ty thành viên để mang lại lợi ích cho toàn bộ hệ sinh thái AI, chẳng hạn như thông qua việc nâng cao các đánh giá và tiêu chuẩn kỹ thuật, cũng như phát triển thư viện công cộng các giải pháp để hỗ trợ các tiêu chuẩn và thực tiễn tốt nhất trong ngành.

Giới làm công nghệ ở Việt Nam vốn rất nhạy bén về công nghệ đã nhanh chóng tham gia cuộc chơi AI, đặc biệt là phát triển các ứng dụng AI tạo sinh. Ông Trung Huỳnh, CEO, nhà sáng lập Actable AI và ChatBD, cho biết AI hiện đang được ứng dụng mạnh mẽ tại nhiều ngành công nghiệp khác nhau tại Việt Nam. AI được ứng dụng trong nhiều lĩnh vực như ngân hàng, y tế, giáo dục, thương mại điện tử,… Và theo ông Vũ Anh Tú, Giám đốc Công nghệ của Tập đoàn FPT, hầu hết các sản phẩm, giải pháp AI đó đều do các công ty công nghệ Việt Nam phát triển.

Vì thế, các cơ quan chức năng của Việt Nam cần phải nhanh chóng vào cuộc, sớm xây dựng bộ khung pháp lý để bảo đảm phát triển và sử dụng AI một cách có trách nhiệm, an toàn ở Việt Nam. Tất nhiên, chúng ta cần tham khảo cách thế giới làm và bảo đảm các quy định mang tính hội nhập quốc tế cao, có thể khai thác tối đa các ưu thế của AI, đồng thời giảm thiểu thấp nhất các mặt trái của nó. Đặc biệt là ngăn ngừa các hành vi lạm dụng công nghệ này cho những mục đích xấu, có hại cho xã hội và vi phạm pháp luật. Song song với bộ khung quản lý của Nhà nước, các tổ chức, hiệp hội có liên quan cũng cần có những bộ quy tắc ứng xử có trách nhiệm trong việc phát triển và sử dụng AI trong lĩnh vực của mình.

Tiến sĩ Geoffrey Hinton, “cha đỡ đầu” của AI, cho rằng cách tốt nhất là giới khoa học hàng đầu thế giới nên tìm cách kiểm soát công nghệ AI. Trước mắt, các công ty không nên mở rộng quy mô đào tạo AI cho đến khi thực sự kiểm soát được nó.

Bản in trên báo Người Lao Động thứ Tư 29-11-2023 và trên báo NLĐ Online.

ANH PHÚC