Dịch vụ Đám mây Mô hình Ngôn ngữ lớn cho trí tuệ nhân tạo và sinh học kỹ thuật số của NVIDIA

Dịch vụ Đám mây Mô hình Ngôn ngữ lớn (Large Language Model, LLM) NVIDIA NeMo LLM Service sẽ giúp các nhà phát triển tùy chỉnh các mô hình ngôn ngữ lớn. Trong khi đó Dịch vụ NVIDIA BioNeMo sẽ giúp các nhà nghiên cứu sinh học kỹ thuật số (Digital Biology) tạo và dự đoán các phân tử, Protein, DNA,…

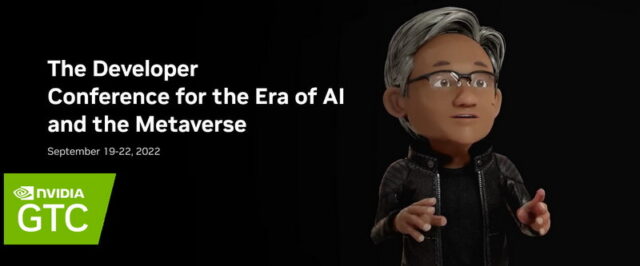

Tại Hội nghị Công nghệ GPU (GTC) 2022 do NVIDIA tổ chức từ ngày 19 đến 22-9-2022, Công ty NVIDIA đã công bố hai dịch vụ AI đám mây mô hình ngôn ngữ lớn mới, đó là Dịch vụ Mô hình Ngôn ngữ lớn NVIDIA NeMo và Dịch vụ NVIDIA BioNeMo LLM cho phép các nhà phát triển dễ dàng điều chỉnh LLM và triển khai các ứng dụng AI tùy chỉnh để tạo nội dung, tóm tắt văn bản, chatbot, phát triển mã, cũng như dự đoán cấu trúc protein và thuộc tính phân tử sinh học,…

Dịch vụ NeMo LLM cho phép các nhà phát triển nhanh chóng điều chỉnh một số mô hình nền tảng được đào tạo trước bằng cách sử dụng phương pháp đào tạo được gọi là học nhanh (prompt learning) trên cơ sở hạ tầng do NVIDIA quản lý. Dịch vụ NVIDIA BioNeMo là một giao diện lập trình ứng dụng đám mây (API) mở rộng các trường hợp sử dụng LLM ngoài ngôn ngữ và sang các ứng dụng khoa học để đẩy nhanh việc khám phá thuốc cho các công ty dược phẩm và công nghệ sinh học.

Ông Jensen Huang, người sáng lập và Giám đốc điều hành NVIDIA, cho biết: “Các mô hình ngôn ngữ lớn có tiềm năng thay đổi mọi ngành công nghiệp. Khả năng điều chỉnh các mô hình nền tảng giúp sức mạnh của LLM trong tầm tay của hàng triệu nhà phát triển, những người hiện có thể tạo ra các dịch vụ ngôn ngữ và cung cấp sức mạnh cho các khám phá khoa học mà không cần phải xây dựng một mô hình lớn từ đầu.”

Dịch vụ NeMo LLM tăng cường độ chính xác với việc học hỏi kịp thời, tăng tốc triển khai

Với Dịch vụ NeMo LLM, các nhà phát triển có thể sử dụng dữ liệu đào tạo của riêng họ để tùy chỉnh các mô hình nền tảng từ 3 tỷ thông số lên đến Megatron 530B, một trong những LLM lớn nhất thế giới. Quá trình này chỉ mất vài phút đến hàng giờ so với hàng tuần hoặc hàng tháng cần thiết để đào tạo một mô hình từ đầu.

Các mô hình được tùy chỉnh với tính năng học tập nhanh chóng, sử dụng một kỹ thuật gọi là p-tuning. Điều này cho phép các nhà phát triển chỉ sử dụng vài trăm thí dụ để điều chỉnh nhanh chóng các mô hình nền tảng đã được đào tạo ban đầu với hàng tỷ điểm dữ liệu. Quá trình tùy chỉnh tạo ra các mã thông báo nhắc nhở theo nhiệm vụ cụ thể, sau đó được kết hợp với các mô hình nền tảng để mang lại độ chính xác cao hơn và các phản hồi phù hợp hơn cho các trường hợp sử dụng cụ thể.

Các nhà phát triển có thể tùy chỉnh cho nhiều trường hợp sử dụng bằng cách sử dụng cùng một mô hình và tạo nhiều mã thông báo nhắc nhở khác nhau. Tính năng playround cung cấp tùy chọn không mã để dễ dàng thử nghiệm và tương tác với các mô hình, thúc đẩy hơn nữa hiệu quả và khả năng tiếp cận của LLM cho các trường hợp sử dụng cụ thể trong ngành.

Sau khi sẵn sàng triển khai, các mô hình đã điều chỉnh có thể chạy trên các phiên bản đám mây, hệ thống tại chỗ hoặc thông qua API.

Dịch vụ LLM của BioNeMo cho phép các nhà nghiên cứu khai thác sức mạnh của các mô hình hàng loạt

Dịch vụ BioNeMo LLM bao gồm hai mô hình ngôn ngữ BioNeMo mới cho các ứng dụng hóa học và sinh học. Nó cung cấp hỗ trợ cho dữ liệu protein, DNA và hóa học để giúp các nhà nghiên cứu khám phá các mẫu và hiểu biết sâu sắc về trình tự sinh học.

BioNeMo cho phép các nhà nghiên cứu mở rộng phạm vi công việc của họ bằng cách tận dụng các mô hình chứa hàng tỷ tham số. Những mô hình lớn hơn này có thể lưu trữ nhiều thông tin hơn về cấu trúc của protein, mối quan hệ tiến hóa giữa các gen và thậm chí tạo ra các phân tử sinh học mới cho các ứng dụng điều trị.

API đám mây cung cấp quyền truy cập vào Megatron 530B và các model sẵn có

Ngoài việc điều chỉnh các mô hình nền tảng, các dịch vụ LLM bao gồm tùy chọn sử dụng các mô hình tùy chỉnh và tạo sẵn thông qua API đám mây.

Điều này cung cấp cho các nhà phát triển quyền truy cập vào một loạt LLM được đào tạo trước, bao gồm Megatron 530B. Nó cũng cung cấp quyền truy cập vào các mô hình T5 và GPT-3 được tạo bằng khung (framework) NVIDIA NeMo Megatron – hiện đã có trong bản beta mở – để hỗ trợ nhiều loại ứng dụng và yêu cầu dịch vụ đa ngôn ngữ.

Các nhà lãnh đạo trong lĩnh vực ôtô, máy tính, giáo dục, chăm sóc sức khỏe, viễn thông và các ngành khác đang sử dụng NeMo Megatron để tiên phong cung cấp dịch vụ cho khách hàng bằng tiếng Trung, tiếng Anh, tiếng Hàn, tiếng Thụy Điển và các ngôn ngữ khác.

Tính khả dụng

Các dịch vụ NeMo LLM và BioNeMo và các API đám mây dự kiến sẽ có trong quyền truy cập sớm bắt đầu từ tháng 10-2022. Các nhà phát triển có thể đăng ký ngay bây giờ để biết thêm chi tiết.

Bản phát hành beta của khung NeMo Megatron có từ NVIDIA NGC và được tối ưu hóa để chạy trên NVIDIA DGX Foundry và NVIDIA DGX SuperPOD, cũng như các phiên bản đám mây tăng tốc từ Amazon Web Services, Microsoft Azure và Oracle Cloud Infrastructure.

Để trải nghiệm khung NeMo Megatron, các nhà phát triển có thể dùng thử miễn phí tại phòng thí nghiệm NVIDIA LaunchPad.

Để tìm hiểu thêm về NVIDIA LLM Cloud Services, bạn đọc có thể tham khảo bài phát biểu chính của GTC 2022 từ CEO Jensen Huang.

Tham khảo: NVIDIA Launches Large Language Model Cloud Services to Advance AI and Digital Biology.

I.L.C.

Nguồn do NVIDIA cung cấp.